NSDT工具推荐: Three.js AI纹理开发包 - YOLO合成数据生成器 - GLTF/GLB在线编辑 - 3D模型格式在线转换 - 可编程3D场景编辑器 - REVIT导出3D模型插件 - 3D模型语义搜索引擎 - AI模型在线查看 - Three.js虚拟轴心开发包 - 3D模型在线减面 - STL模型在线切割 - 3D道路快速建模

很少有人喜欢他们用来完成工作的软件。原因并不奇怪。无论是幻灯片制作器、视频编辑器还是照片增强器,当今的工作工具都是几十年前构思出来的——而且很明显!即使是一流的产品,也常常感觉要么太不灵活、太不成熟,无法完成实际工作,要么学习曲线陡峭、难以理解(我们说的就是你,Adobe InDesign)。

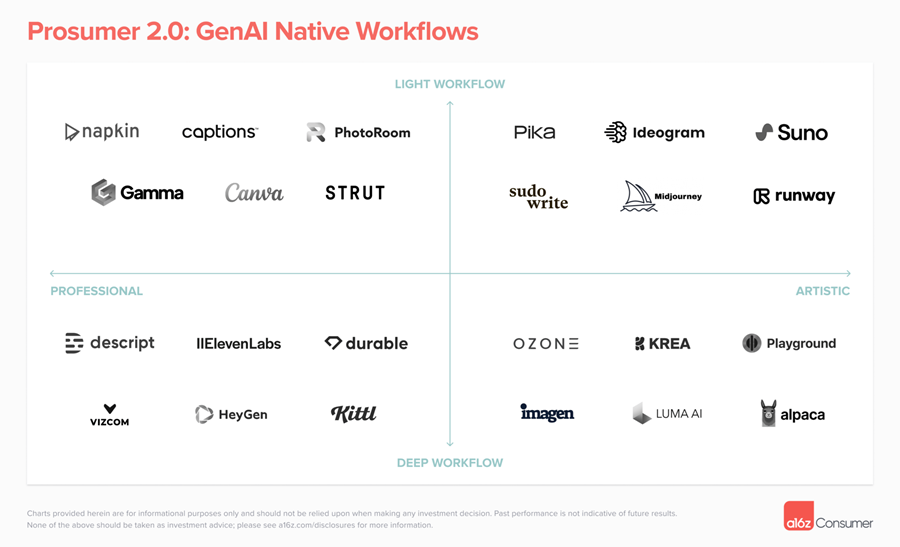

生成式AI为创始人提供了彻底改造工作流程的机会——并将催生一批新的公司,这些公司不仅是AI增强的,而且是完全AI原生的。这些公司将从头开始,利用我们现在拥有的技术,围绕人工智能独有的生成、编辑和合成功能构建新产品。

从最表面的层面来看,我们相信人工智能将帮助用户更有效地完成现有工作。 AI 原生平台将“提升”用户与软件的互动,使他们能够将技能要求较低的任务委托给 AI 助手,而将时间花在更高层次的思考上。这不仅适用于传统的办公室工作人员,也适用于小企业主、自由职业者、创作者和艺术家——他们的时间需求可能更加复杂。

但 AI 还将帮助用户在技术和审美层面解锁全新的技能组合。我们已经在 Midjourney 和 ChatGPT 的代码解释器等产品中看到了这一点。现在每个人都可以成为程序员、制作人、设计师或音乐家,从而缩小了创造力和手艺之间的差距。通过获得具有 AI 驱动的工作流程的专业级但消费者友好的产品,每个人都可以成为新一代Prosumer(生产消费者)的一部分。

在本文中,我们旨在重点介绍当今和未来最成功的 Gen AI 原生工作流程的特点,并假设我们如何看待这些产品的发展。

1、GenAI原生产品将会是什么样子?

所有具有 Gen AI 原生工作流程的产品都将具有一个关键特征:将尖端模型转化为可访问、有效的用户界面。

工作流程工具的用户通常不关心产品背后的基础设施是什么;他们关心的是它如何帮助他们!虽然我们在生成式AI方面取得的技术飞跃令人惊叹,但成功的产品仍然需要从对用户及其痛点的深刻理解开始。人工智能可以抽象出什么?需要批准的关键“决策点”在哪里(如果有的话)?最高杠杆点在哪里?

我们认为此类别的产品将具有以下几个关键功能:

1.1 生成工具可以消除“空白页”问题

最早和最明显的消费者AI用例来自将自然语言提示转换为媒体输出——例如图像、视频和文本生成器。Prosumer产品也是如此。这些工具可能有助于转换真正的“空白页”(例如,幻灯片中的文本提示),或获取增量资产(例如,草图或大纲)并将其转变为更充实的产品。

一些公司会通过专有模型来实现这一点,而其他公司可能会在幕后混合或拼接多个模型(开源、专有或通过 API)。这里的一个例子是 Vizcom 的渲染工具。用户可以输入文本提示、草图或 3D 模型,并立即获得逼真的渲染以进一步迭代。

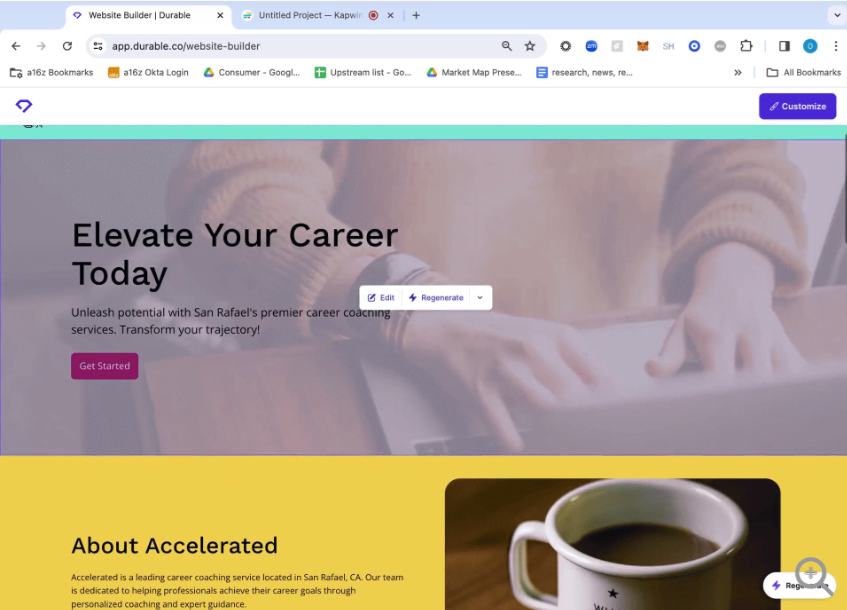

另一个例子是 Durable 的网站构建器产品,该公司表示,该产品迄今已用于生成超过 600 万个网站。用户输入公司名称、部门和位置,Durable 就会生成一个供他们定制的网站。随着 LLM 功能越来越强大,我们期望看到像 Durable 这样的产品从互联网和社交媒体的其他地方提取有关你企业的真实信息(历史、团队、评论、徽标等),并仅用一代产品就能生成更复杂的输出。

1.2 多模态(和多媒体!)组合

许多创意项目需要多种类型的内容。例如,你可能希望将图像与文本、音乐与视频或动画与画外音相结合。截至目前,还没有一个模型可以生成所有这些资产类型。这为工作流产品创造了机会,这些产品允许用户在一个地方生成、优化和拼接不同类型的内容。

HeyGen 的头像产品就是此类工具的一个例子。该公司将自己的头像和口型配音模型与 ElevenLabs 的文本转语音 API 相结合,以创建逼真的、会说话的视频头像(在此处查看 Justine 的头像)。

HeyGen 的产品还有模板和 Canva 式的编辑器,可将头像放入幻灯片或视频中、创建幻灯片或添加文本或其他资产,无需将头像带到 Powerpoint 或 Google Slides。

1.3 智能编辑器可实现更多迭代

几乎没有任何工作产品是“一次性”的——尤其是人工智能,因为每一代都具有固有的随机性。第一次运行时很少能得到你想要的东西。点击重新生成按钮和/或修改提示是这个过程的关键,但耗时且令人沮丧。

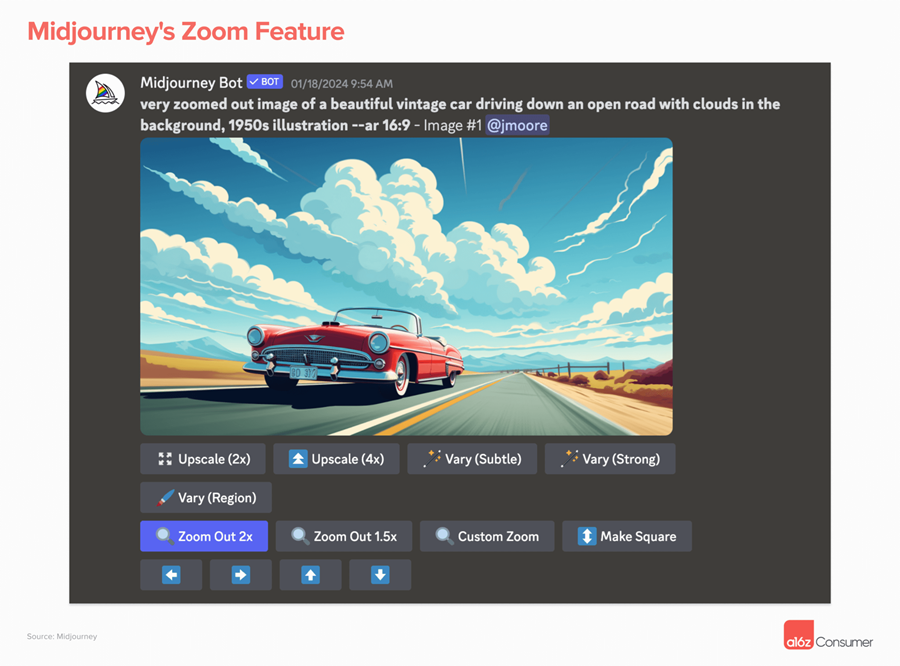

第一波人工智能生成产品不允许任何迭代:你创建了一个图像(或视频或音乐),仅此而已。如果你重新运行相同的提示,你会得到完全不同的结果。我们现在开始看到一些功能,使用户能够获取现有输出并对其进行改进,而无需完全从头开始。Midjourney 的变化和缩放工具就是一个很好的例子。

在视频方面,Pika 提供了类似的功能。用户可以截取已制作的片段并修改特定区域,例如更改角色的性别或头发颜色,或者添加或删除对象。用户还可以通过修复现有视频周围的空白区域来扩展画布。

1.4 平台内优化

智能编辑的另一个关键(相关)元素是优化;最后 10% 的润色工作往往决定了创作出的作品是好作品还是伟大作品。但这可能具有挑战性:(1)找出需要优化的地方;(2)在无需使用其他产品的情况下进行这些优化。

AI 工作流产品可以帮助用户识别可以改进的地方,然后自动进行这些改进。可以将其想象成 Apple 的照片“自动修饰”功能,但可以将其想象成任何东西的“自动修饰”!

对此最直观的解释是升级,Krea 等平台提供了此功能。在一个界面中,用户可以生成图像或设计,然后对其进行增强 — 让它们更接近最终产品。

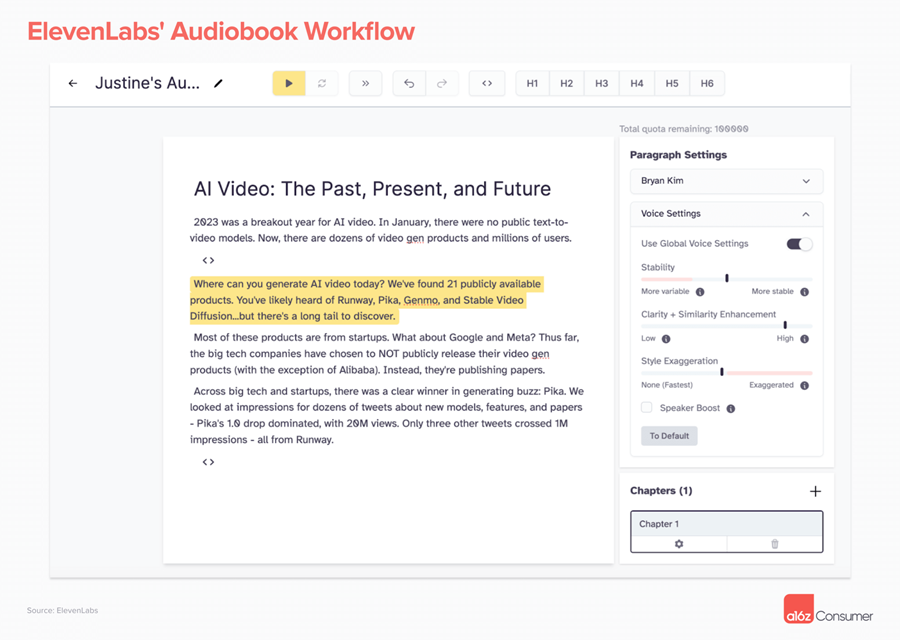

ElevenLabs 的有声读物工作流程是另一个很好的例子。您可以使用该工具为特定角色生成声音来叙述书中的各个部分,然后通过调整句子或短语的停顿、稳定性或清晰度来完善输出。

1.5 可混编和可转换的输出

人工智能使内容具有独特的灵活性——每一段内容都是另一次迭代的潜在“起点”。如果你曾经在 Midjourney 或 ChatGPT 中复制和调整过其他人的提示,那么你就参与了其中。

发挥这种灵活性的平台可能会构建更强大、更具粘性的产品。对于最初的创作者来说,能够跨媒介转换你的作品具有巨大的价值,例如,将视频变成博客文章,或将文本解释器变成操作方法动画视频。这是 Gamma 发布平台的核心功能。用户可以从提示或上传的文件生成卡片组、文档或网页,并在需要时切换格式。

从面向外部的角度来看,这些产品可以让用户公开他们的工作流程,供其他人进行迭代。这可能是一系列提示或模型组合——或者只是一个“复制”按钮,供技术水平较低的用户模仿输出或美学。

Imagen AI 是一个面向专业摄影师的编辑平台,就是一个例子。该公司根据每位摄影师的个人风格训练模型,使他们能够更轻松地进行批量编辑。不过,用户也可以选择以在平台上提供个人资料的行业领先摄影师的风格进行编辑。

2、GenAI原生产品将如何发展?

下一代的产消合一的AI工具仍处于早期阶段。虽然现有工具生成核心资产的能力终于强大到足以添加有意义的工作流程,但大多数产品仍然只专注于一种类型的内容——而且功能相当有限。以下是我们希望在未来几个月看到的几件事:

2.1 结合内容模式的编辑工具

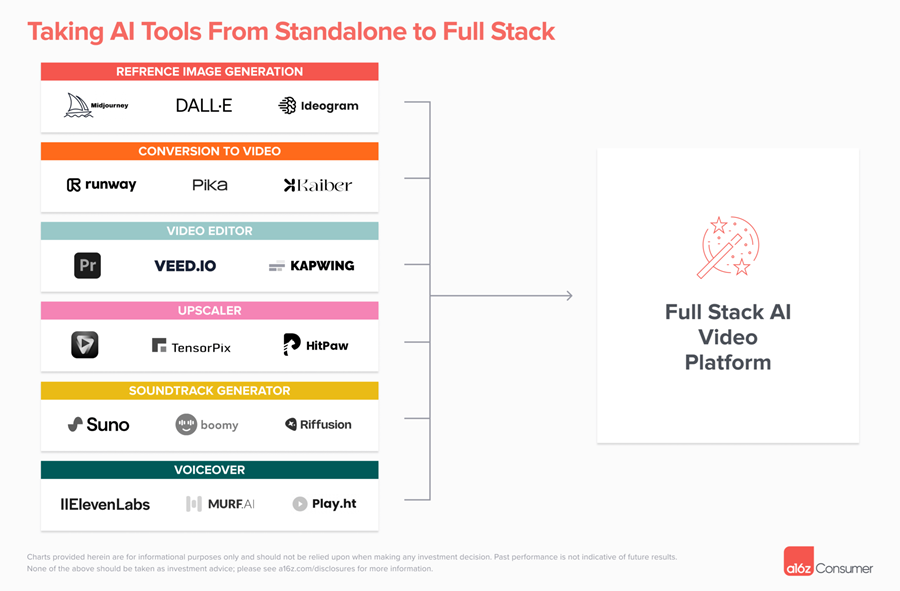

视频可能是最好的例子。今天,使用人工智能制作短片需要在 Pika 或 Runway 等产品中生成多个剪辑,然后将它们移动到 Capcut 或 Kapwing 等另一个平台进行编辑或混音(或添加在其他地方生成的声音!)。

如果你可以在一个平台上完成这个过程的每一步会怎么样?我们预计一些新兴一代产品将能够添加更多工作流程功能,并扩展到其他类型的内容生成——这可以通过训练自己的模型、利用开源模型或与其他参与者合作来实现。我们还可能会看到一个新的独立的、人工智能原生编辑器的出现,使用户能够“插入”不同的模型。

2.2 使用不同交互模式的产品

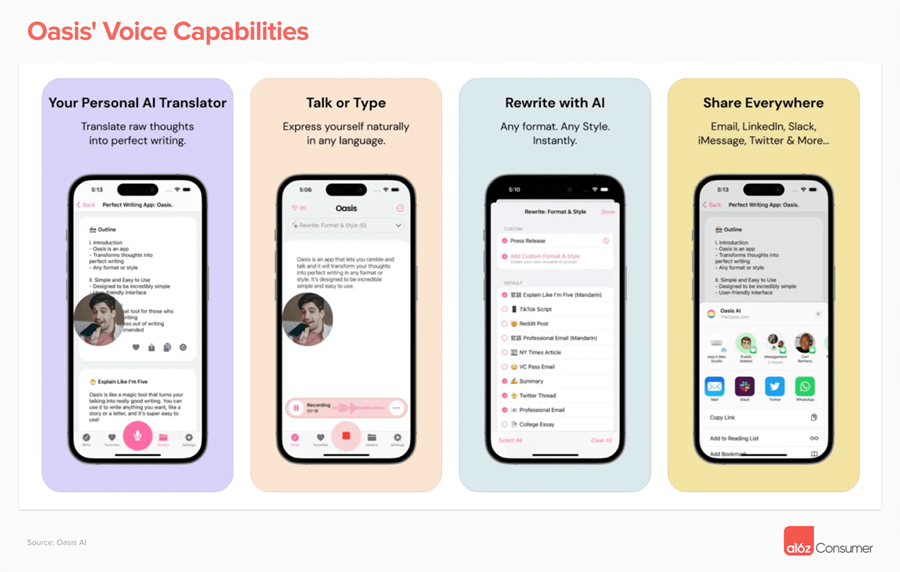

文本提示并不总是与 AI 产品沟通的最有效方式。我们相信,你应该能够像与人类头脑风暴伙伴合作一样使用生成工具——无论是通过语音、草图还是分享 inspo 照片。

我们对语音作为一种允许用户分享更复杂想法的方式(或者简单地以文本无法实现的方式闲聊)感到特别兴奋。此类产品已经开始出现,Oasis、TalkNotes 和 AudioPen 都能够将语音笔记转换为电子邮件、博客文章或推文。我们预计音频甚至视频作为输入源将出现在更多工作流程产品中,从而改变用户完成工作的方式和时间。

2.3 将人类和AI生成的内容视为平等的产品

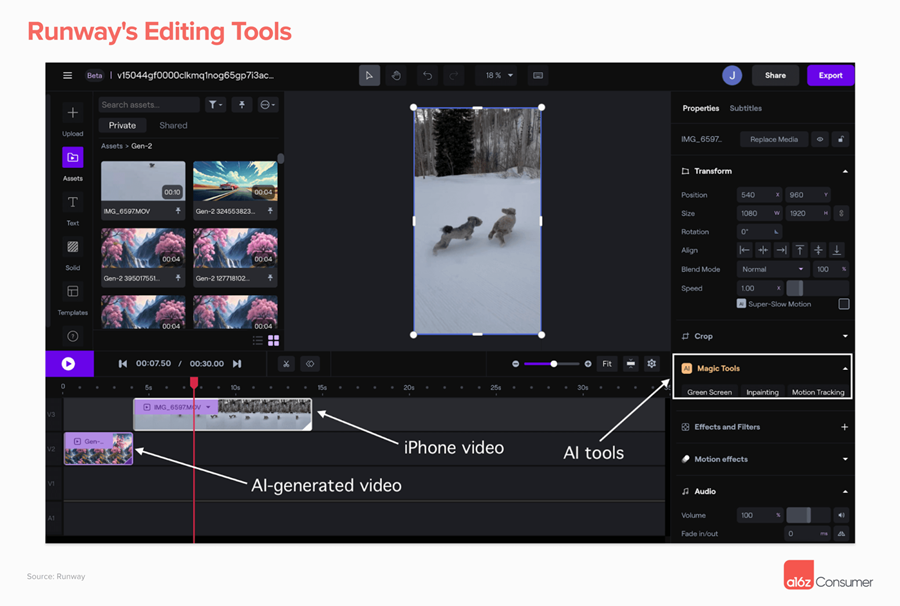

我们希望看到能够让你同时使用AI和人类内容的工具。当今大多数产品都专注于其中之一。例如,它们擅长增强真实照片,但对人工智能图像却无能为力。或者它们可以生成新视频,但无法增强或重新设计 iPhone 上的剪辑。

未来,我们预计大多数专业内容制作者将同时使用人工智能和人类生成的内容。他们使用的产品应该可以同时处理这两种类型的内容,甚至使它们更容易结合使用。Runway 的编辑工具就体现了这一点。你可以从公司的生成模型中提取剪辑和图像,并上传真实资产以在同一时间线中使用。然后,你可以在这两种类型的内容上使用公司的“神奇工具”,例如修复和绿屏。

我们在此重点介绍的内容工作流产品只是未来专业消费者软件的一个重要组成部分。稍后再来深入探讨第二个关键组成部分——生产力工具——我们认为这些工具在人工智能时代同样适合重新发明。

原文链接:The Future of Prosumer: The Rise of “AI Native” Workflows

BimAnt翻译整理,转载请标明出处